作者:赵宜哲

一、参赛信息

aPaaS实现多系统告警的集中处理和精准推送,显著提高告警响应的效率和准确性。

二、应用信息

应用名称:IT告警中心

命名空间 :package_copyc5p3s__c

三、应用背景

IT 作为企业的信息中枢,日常工作中需要接收和处理大量的告警信息。有些时候,告警往往来源多个系统,而让工程师在多个系统间切换、处理告警是不现实的,也不利于告警的解决。而且企业可能对某一类的告警有着较高的 SLA 要求,因此必须保证当告警发生时,需要将告警实时、精准的推送到工程师手中。

在这个场景下,可以基于 aPaaS ,低成本地将告警在平台侧做告警的聚合,并根据特定的规则对告警进行推送。实现多个系统的告警统一处理、记录和管理。

四、项目价值

使用aPaaS前 | 使用aPaaS后 |

🔴 告警仅能做记录,无法有效追溯问题 | ✅ 及时准确低将告警推送至相关方,并且实现竞争抢单 |

🔴 无法实现对告警的订阅 | ✅ 订阅功能让感兴趣的人订阅感兴趣的告警。 |

五、核心功能

功能 1: 告警接收

对于不同告警平台的告警,可以使用不同的接口对告警信息进行接收。

接收方式主要为 aPaaS 平台向外部系统暴露一个可访问的地址。

功能 2:告警存储

对于处理多种来源的告警,有两种参考的方案实现对告警信息的存储。

方案一:

一张数据表存储所有的告警信息,通过告警的来源区分不同类型的告警。

方案二:

不同来源的告警信息,存储在专门的告警记录表格中,专表专用。

方案一的模型字段参考。

功能 3:告警过滤

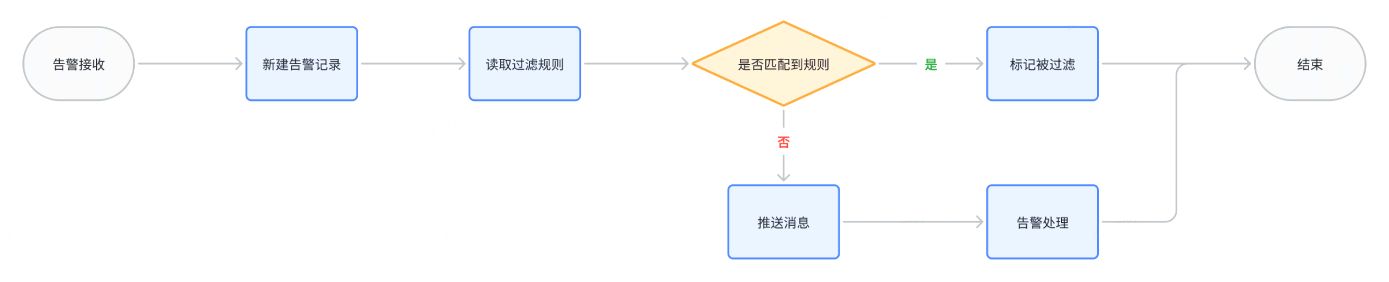

整体的告警接收、过滤、推送可参考下方的建议流程图。

250px|700px|reset

在流程图内,对于过滤规则的制定,根据业务需求,可以设定为:

- 对时间范围的过滤

- 法定假期不推送告警

- 对告警地点的过滤

- 站点新建、退租等

- 对告警来源的过滤

- 告警源维护升级时

- 对告警设备的过滤

- 例如设备维护时

- 个性化定制过滤规则

- 当某个设备告警达到第几次时,才推送告警;

- 当某个告警原因短时间内推送多次时,屏蔽告警。

- ……

功能 4:告警推送

当告警发生时,经过过滤规则的匹配后,对于已经命中过滤规则的告警,则仅需要记录过滤的状态和命中的过滤规则即可。但是对于未命中过滤规则的告警,需要及时地将告警信息通过飞书消息卡片,推送到指定人员飞书内。

在消息卡片中,可以增加接单按钮和结果反馈按钮。大致实现效果可参考下方。

250px|700px|reset

如果告警消息的接收人存在多个人员,则在此模块内,还可以加入抢单机制。

具体流程如下:

功能 5:告警处理

告警处理人接收到告警后,接下来就需要处理告警。结束后在系统中完成对告警的结果反馈。

这一动作可以在系统的 Web 页面中完成,也可以基于告警发送的飞书消息卡片,直接完成对告警结果的反馈。在视频中,点击对应的反馈结果后,会将信息直接会写到 aPaaS 平台中,更新告警的结果。

250px|700px|reset

功能 6:告警结果验证

如果对应的告警源支持在告警恢复后,将告警恢复的通知发送至其他平台,则可以在 aPaaS 中开放告警恢复的消息订阅。当 aPaaS 接收到某一告警的恢复消息后,可以检查该告警是否已经推送至特定人员,如果存在,则可以主动告知接收人,告警已经恢复。

六、解决方案与展示

模块解决方案

整个应用中,使用到了以下 aPaaS 能力,来解决相关的业务功能需求。

步骤 | 解决方案 |

功能1:告警接收 | Webhook 触发流程,低代码写入数据 |

功能2:告警存储 | 汇总存储,专表存储 |

功能3:告警过滤 | 过滤规则读取,Redis计数匹配 |

功能4:告警推送 | 飞书消息卡片 |

功能5:告警处理 | 飞书消息卡片 - 功能交互 |

功能6:告警结果验证 | Webhook 触发流程、飞书消息卡片 - 功能交互 |

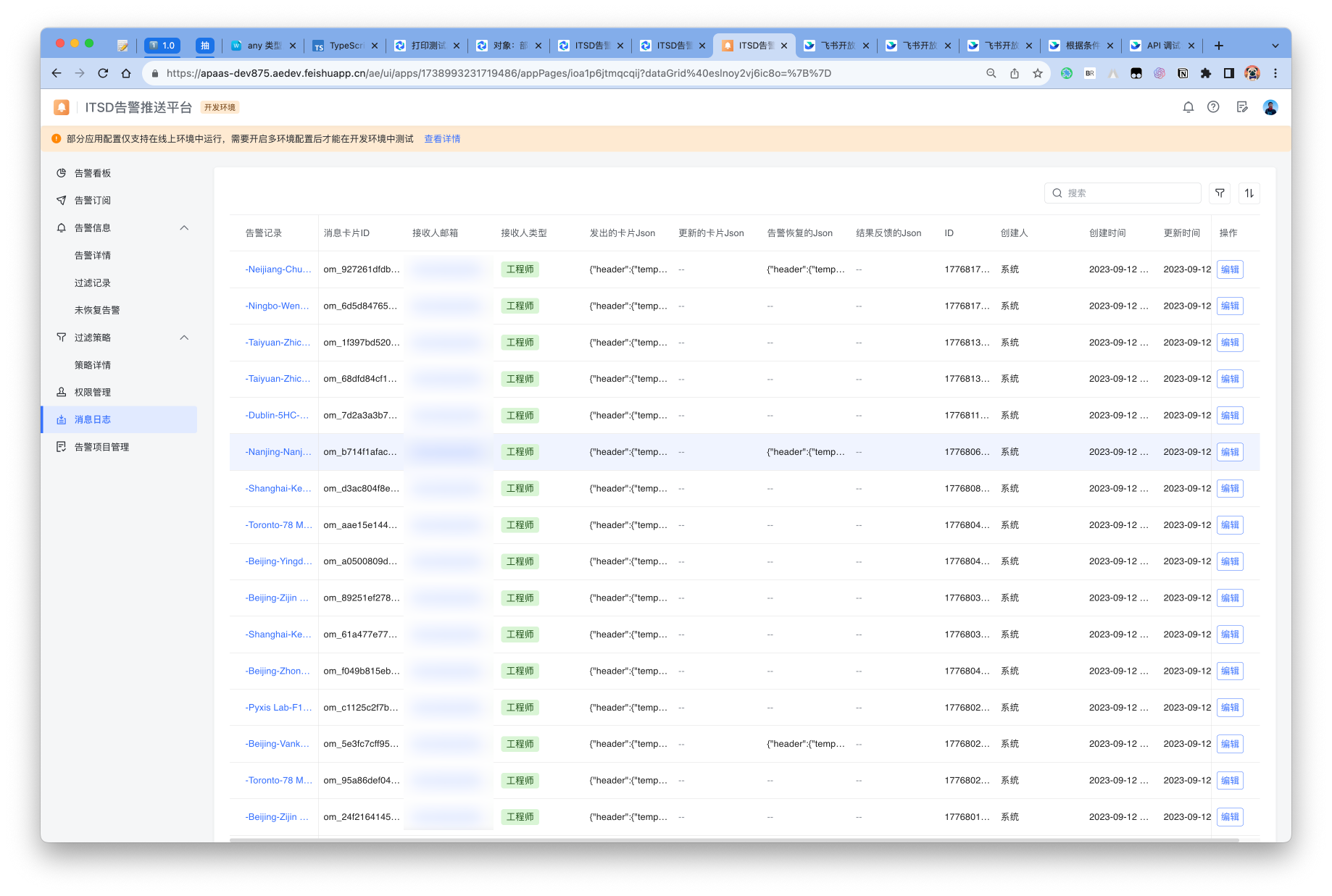

功能及页面展示

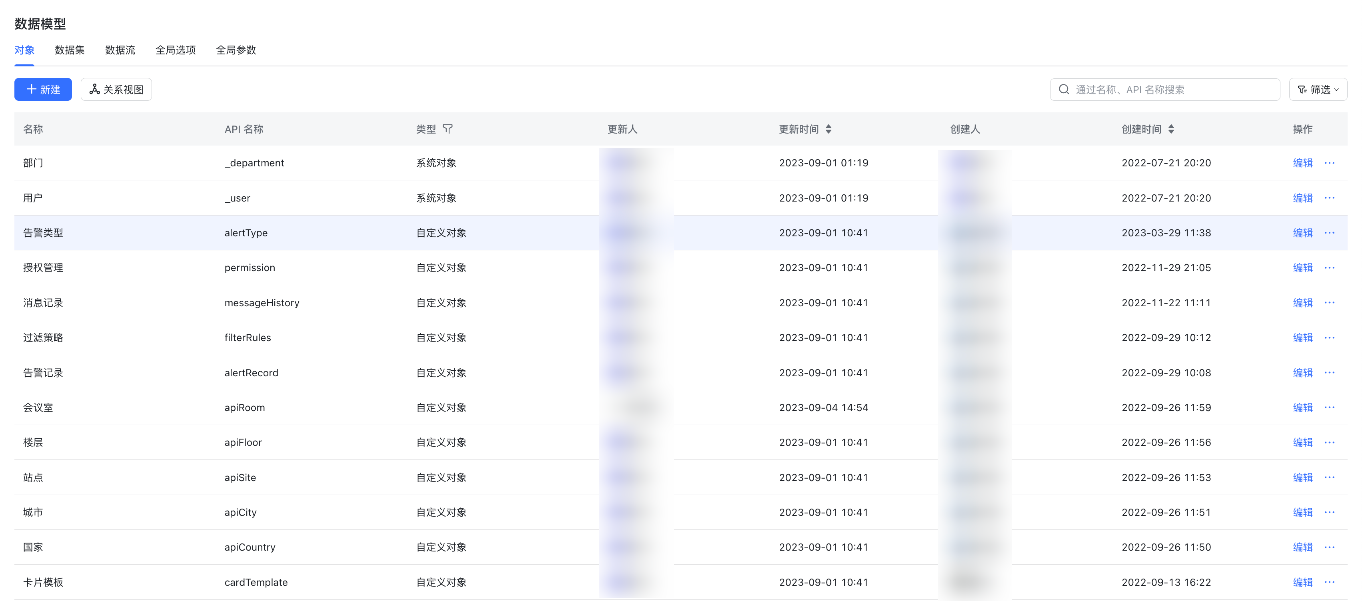

后台配置

250px|700px|reset

250px|700px|reset

250px|700px|reset

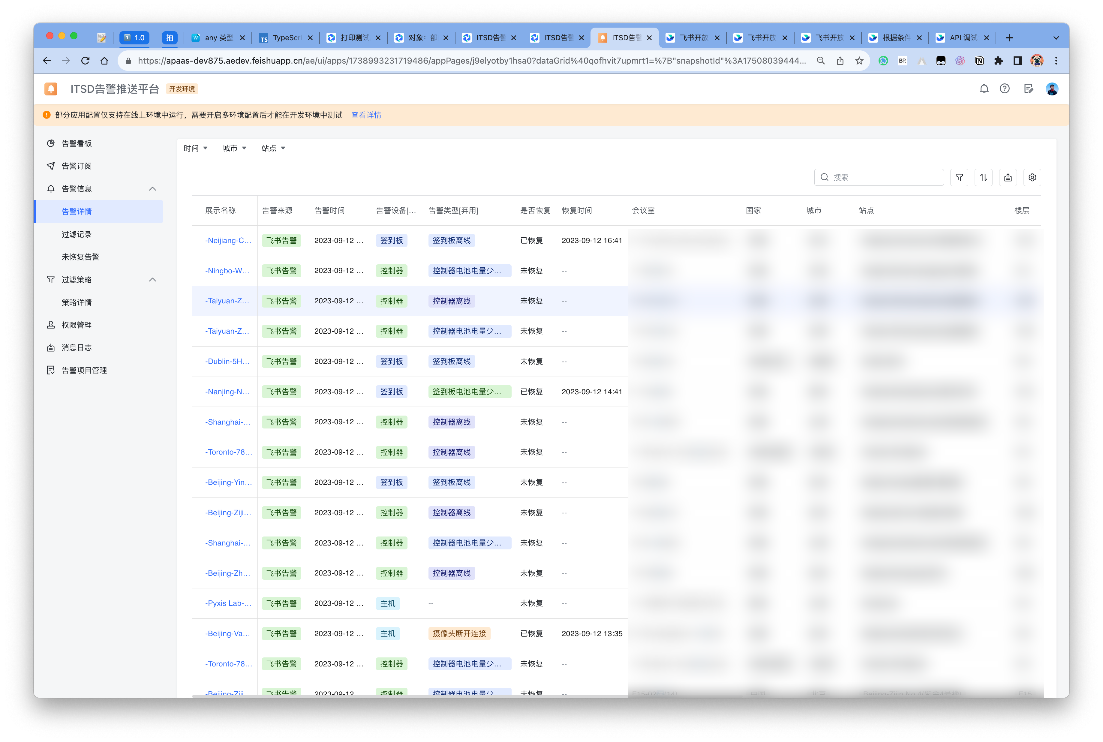

前端页面

250px|700px|reset

250px|700px|reset

七、功能扩展

告警 SLA

如果对不同的告警有不同的 SLA 要求,则可以基于告警来源、告警设备、告警原因等字段指定详细的 SLA 规则,然后根据告警的发生时间、接单时间、处理时间等字段来计算是否满足 SLA 要求。

CMDB 配置同步